Os CCDs são detectores de silício que convertem fótons em elétrons. Cada elemento do detector é chamado de um píxel, uma contração de picture element.

Para a leitura do número de elétrons em cada pixel, eles são transferidos para o registrador horizontal e depois para o elemento de saída, seqüencialmente. Depois a corrente elétrica passa por um conversor analógico-digital (ADC) e a imagem resultante está digitalizada.

Processamento dos Dados

Os dados crus são processados utilizando as diversas formas de exposições para calibração feitas todas as noites. Essas exposições consistiram em imagens de "bias", que são imagens com tempos de exposição nulos, e flatfields, que precisam ser obtidos expondo o CCD a uma tela uniforme iluminada por uma lâmpada, dentro da cúpula, ou ao céu logo depois do por-do-sol ou logo antes do nascer do sol, nos chamados sky flats. Nos telescópios acima de 4 m de diâmetro é difícil ter telas planas devido ao seu enorme tamanho.O objetivo da maioria dos dados de calibração é remover os efeitos aditivos, como o nível do pedestal eletrônico (medido na região do overscan em cada frame), o nível de "pre-flash" (medido nos imagens de bias), e, se necessário, a corrente escura (medida em imagens de longa exposição não expostos à luz, os darks). Os dados de flat-field irão remover os ganhos multiplicativos (diferenças de ganho pixel a pixel) e variações de iluminação através do sensor (chip). As operações não são comutativas, isto é, a ordem das operações é necessariamente esta:

- subtração de overscan (sobre-leitura)

- subtração de bias (viés eletrônico)

- correção por flat (variações de sensibilidade)

- correção por dark (corrente de escuro, térmica)

- análise: fotometria ou espectroscopia

Existem vários programas para redução de dados. O mais utilizado é o IRAF - Image Reduction and Analysis Facility, do NOAO - National Optical Astronomy Observatory. Este vídeo mostra como instalar o IRAF, e o vídeo mostra como usar.

Use

ccdlist nome_da_imagem.fits

para listar as extensões do arquivo fits.

Para encontrar a região de overscan, no

IRAF,

faça um

implot nome_da_imagem.fits[n]

(use l para plotar uma linha, r para plotar uma coluna (row)

ou

display nome_da_imagem.fits[n] 1

para cada extensão n da imagem não tratada, raw=crua.

Cuide para que o display tenha resolução suficiente para ver os

píxeis individuais, alterando o parâmetro

para cada extensão n da imagem não tratada, raw=crua.

Cuide para que o display tenha resolução suficiente para ver os

píxeis individuais, alterando o parâmetro

set stdimage = imt2048

no seu login.cl do IRAF, para o imt adequado.

Faça um zoom até ver os píxeis indivualmente,

e verifique quais

os píxeis que estão abaixo de um nível de céu médio, logo

no início ou fim da imagem. Por exemplo, nas imagens do SOI

(Soar Optical Imager), as contagens estão próximas a 3500,

se a binagem (binning) for 2×2. No header

tem o TRIMSEC com esta informação, mas muitas vezes ela está errada.

Para o SOI 2×2:

- Amplificadores 1 e 3

BIASSEC = [541:568,1:2048] TRIMSEC = [29:540,1:2048]

- Amplificadores 2 e 4

BIASSEC = [8:28,1:2048] TRIMSEC = [29:540,1:2048]

A seguir damos uma explicação mais detalhada da necessidade de cada um desses passos, e como são feitos:

Em um detector CCD, quando a luz incide na sua superfície, elétrons constituindo um pacote de carga são produzidos e colectados em uma determinada área definida por um eletrodo carregado positivamente. A superfície do CCD é constituído por várias dessas áreas, chamadas pixeis (elementos de imagem). Quando se completa a exposição, os elétrons colectados são transportados para um amplificador, e para um conversor analógico- digital, que transforma a carga em cada pacote em um número binário que ao ser lido pelo computador é traduzido como o número de contagens (N), utilizando um certo ganho (número de elétrons que serão representados por uma contagem, ADU, unidade analógico-digital, ganho=e-/ADU).

Ao obter as imagens (frames) no telescópio, o sinal de saída (o número de contagens N) fica "elevado" devido a um pedestal (bias) surgido no processo de leitura do sinal (viés eletrônico de leitura). Esse bias varia com a posição no chip, principalmente ao longo das colunas, variando pouco ao longo das linhas. Para removê-lo usa-se os dados na região do overscan, que são algumas colunas na margem do frame, não expostas à luz. As colunas de overscan podem ser virtuais, ou seja, criadas somente através do código de leitura.

Para fazer a subtração, todas as colunas da região do overscan são pro-mediadas em uma só coluna, e a essa coluna é ajustada uma função suave: spline, Legendre [Adrien-Marie Legendre (1752-1833)] ou Chebyshev [Pafnuty Lvvich Chebyshev (1821-1894)], do número da linha. A função ajustada é então subtraída de todas as colunas da imagem.

Neste ponto, toda a região do overscan é recortada da imagem, juntamente com as primeiras e últimas colunas de dados, onde os efeitos de borda são importantes, de forma a manter somente a parte da imagem que contém dados úteis. Esse procedimento de subtração do overscan e recorte das imagens é aplicado a todos as imagens: bias, flatfields, darks (se houver) e objeto.

Se o frame foi pré-exposto à luz antes de ser exposto ao telescópio, o que às vezes é necessário para "aquecer" os pixeis de forma a eles passarem a ter uma resposta linear ou aumentar a transmissão dos elétrons acumulados em cada pixel, haverá ainda uma quantidade não nula de contagens superpostas à imagem. Embora este pre-flash não seja mais utilizado, o bias ainda é utilizado para remover contagens residuais pixel-a-pixel. Para remover esse sinal, além de possíveis variações ao longo das linhas, ainda não corrigidas com o procedimento anterior, usam-se os frames de bias. Esses frames são combinados para minimizar os efeitos de ruído, raios cósmicos, e rejeitar pixeis ruins (pixeis com transmissão não linear); o frame final, Zero, é subtraído de todos os outros tipos de imagens: flatfields, darks e objeto.

Em alguns CCD's, existe também uma quantidade não desprezível de corrente de escuro, térmica, adicionada em longas exposições. Para removê-la, se tomam imagens com exposições de mesmo tempo de exposição que as imagens científicas, com o diafragma fechado, chamados darks. Os darks são submetidos a todos os passos de pré-processamento descritos até aqui.

O próximo e último passo é fazer a correção do planicidade (flatfield), que irá remover as variações de ganho pixel a pixel. Isso é feito combinando as imagens de flatfield da mesma forma que foram combinadas as imagens de bias, porém agrupadas por filtro, e a imagem final em cada filtro é normalizada. Os flats devem ser obtidos dentro da região de linearidade do CCD, em geral abaixo de 60% do nível de saturação, em número suficiente para uma boa média. Em geral um superflat, obtido com a média de exposições em vários dias, é mais confiável do que as médias diárias, desde que não haja diferença na poeira na janela do detector. A imagem de objeto em cada filtro é dividida pelo flatfield correspondente.

O procedimento para esta etapa pode ser sumarizado através da equação:

Nfinal(i)=[Nmedido(i)-Overscan-Zero(i)]/Flatfield(i)

onde Nfinal(i) se refere ao número de contagens em

cada pixel na

imagem final (i varia de 1 ao número total de pixeis),

Nmedido(i) se

refere ao número de contagens em cada pixel na imagem inicial,

Overscan é o pedestal eletrônico

da coluna de leitura, Zero(i) é o bias de cada

pixel, e Flatfield(i)

é a média final de todos os flatfield no filtro, já

normalizada.

O ganho e o ruído de leitura do CCD podem ser obtidos

medindo-se duas imagens de flat

e duas imagens de bias. Por exemplo, no IRAF, a tarefa findgain

utiliza estas quatro imagens para calcular o ganho, usando o método

de James R. Janesick, 2001,

Scientific Charge-Coupled Devices (SPIE Press Monograph Vol. PM83).

flatdif = flat1 - flat2

biasdif = bias1 - bias2

Ganho(e_per_adu) = {[mean(flat1)+mean(flat2)] - [mean(bias1)+mean(bias2)]} / {[rms(flatdif)]2 - [rms(biasdif)]2}

Ruído de Leitura = Ganho × rms(biasdif) / sqrt(2)

levando-se em conta que o único ruído nos bias é o ruído de leitura.

biasdif = bias1 - bias2

Ganho(e_per_adu) = {[mean(flat1)+mean(flat2)] - [mean(bias1)+mean(bias2)]} / {[rms(flatdif)]2 - [rms(biasdif)]2}

Ruído de Leitura = Ganho × rms(biasdif) / sqrt(2)

Para construir uma só imagem a partir das várias extensões, uma por amplificador, usa-se uma tarefa para fazer o mosaico das partes. Para o SOI extiste um script IRAF chamado soimosaic.cl, que assume que a diferença entre os dois CCDs é de x=102 e y=5 píxeis, antes da binagem. O script leva em conta a binagem escrita no header.

Fontes de Ruído

A equação do CCD descreve as contribuições dos diversos tipos de ruído nas medidas. Suponhamos que temos| número total de contagens coletadas do objeto (em elétrons) | |

|

|

número de pixels considerados |

| número de pixeis de fundo (céu) | |

| número total de contagens por pixel de fundo (céu, em elétrons) | |

| número total de contagens por pixel de corrente de escuro (térmicos, em elétrons) | |

| ruído de leitura por pixel (em elétrons) | |

| Ganho do detector (número de elétrons/ADU) | |

Determinação do Céu

O fluxo proveniente do objeto, Fo, vem superposto ao fluxo do céu, Fc, de forma que o sinal do objeto é obtido como:

Fo=Fo+c-Fc

O brilho do céu noturno tem como componentes principais o

airglow (luz emitida pelo átomos e moléculas na alta atmosfera

ao se chocarem com o vento solar), a luz zodiacal (luz solar

espalhada pela poeira inter-planetária concentrada no plano da

eclíptica), a luz solar espalhada pela Lua (é a principal

componente se a Lua está acima do horizonte), e a luz estelar

espalhada pela poeira interestelar.

A determinação do brilho do céu é feita ajustando uma função à distribuição de intensidades dos pixeis em várias regiões livres da contaminação de estrelas ao redor do objeto. Normalmente é usado um polinômio de baixa ordem, visto que polinômios de alta ordem podem introduzir efeitos não físicos, pois se corre o risco de ajustar o erro do céu, em vez do valor do céu. Quando não existem gradientes evidentes de brilho do céu, o que é comum em CCD's devido a seu pequeno tamanho, pode- se usar o céu como um valor constante. Nesse caso pode-se calcular o modo (valor mais freqüente), ou a mediana ou mesmo a média da distribuição de intensidades em diferentes regiões do frame, e depois pro-mediar os valores de céu obtidos de forma a obter o valor final do brilho do céu. A expressão final para o valor do brilho do céu, medido em um determinado pixel da imagem não contaminado por estrelas ou galáxia, e que tem um número de contagens Nc, em magnitudes instrumentais (não calibradas), é :

onde t é o tempo de exposição da imagem. Para expressar o brilho do céu em unidades de magnitude por segundo de arco ao quadrado (m/"2), devemos dividir o número de contagens também pela área angular de cada pixel.

Uma boa determinação de céu é crucial nos níveis de baixo brilho superficial, e uma determinação incorreta do céu introduz grandes erros nas partes externas dos perfis de brilho e nas isofotas correspondentes. Se o brilho do céu for super-estimado, os perfis tendem a cair muito depressa na parte externa, e as isofotas ficam acumuladas nessa região. Se, pelo contrário, o brilho do céu for sub-estimado, os perfis cairão muito devagar na parte de fora, estendendo o objeto além de seu limite real, e as isofotas ficam mais separadas.

Variações na medida do céu no ESO Paranal, em magnitudes por segundo de arco ao quadrado

Calibração Fotométrica

A calibração fotométrica consiste em converter o sistema instrumental, constituído pelo conjunto CCD+filtro, para um sistema padrão. As maneiras mais usuais de fazer isso são:- Através de medidas de estrelas padrões.

Seleciona-se um conjunto de estrelas padrões de cores

diferentes e mede-se o fluxo de cada estrela em cada um dos filtros.

A magnitude instrumental de cada estrela, numa banda (filtro), é

determinada pela expressão

onde N(i,j) é o número de contagens referente ao pixel da estrela localizado na linha i e coluna j, sendo que o somatório se faz dentro de um diafragma circular de raio tal que englobe toda a estrela, Nc é o número de contagens do céu e t é o tempo de exposição. Por exemplo, calculamos as magnitudes B, V, R, e I, e as cores B-V, V-R, V-I e R-I.

Uma vez tendo-se obtido as magnitudes e cores instrumentais, ajustam-se ao conjunto de pontos obtidos para cada banda, retas do tipo

onde mp(i) é a magnitude padrão para a estrela i na banda, mo(i) é a magnitude instrumental m(i) corrigida por extinção atmosférica, Cp é uma cor no sistema padrão e Co é a mesma cor no sistema instrumental, corrigida por extinção atmosférica. As constantes a e a' são os termos de cor e as constantes b e b' são os pontos zeros.

- Através de fotometria fotoelétrica em múltiplos

diafragmas, para objetos extensos.

Faz-se fotometria fotoelétrica em multi-aberturas do

objeto no sistema padrão. Depois comparam-se as magnitudes

integradas obtidas pela fotometria fotoelétrica com magnitudes

integradas obtidas com o CCD dentro da mesma abertura. Então, em

vez de se ter um conjunto de medidas de diferentes estrelas,

tem-se um conjunto de medidas de diferentes diafragmas para o mesmo

objeto.

Identificando cada diafragma i pelo seu raio

ri,

teremos, para cada banda, um conjunto de equações:

Correções a Serem Aplicadas às Magnitudes

As magnitudes observadas e cores integradas de galáxias sofrem de três tipos de efeitos de extinção: a absorção galáctica, devido à poeira dentro da nossa galáxia, a absorção produzida por obscurações internas nas galáxias, e o efeito do "redshift", que é o avermelhamento devido à recessão das galáxias. Outro efeito que pode alterar as magnitudes e cores é o "seeing", que é o alargamento das imagens estelares devido à turbulência atmosférica. O seeing não afeta as magnitudes totais, mas afeta as magnitudes integradas até um certo raio e, portanto, as magnitudes superficiais, pois altera a distribuição espacial de energia.Absorção Galáctica

Muitas tentativas têm sido feitas de determinar o método mais adequado para determinar o avermelhamento sofrido pela luz provinda de objetos extragaláticos ao cruzar a nossa galáxia até a posição da Terra, apesar do que ainda não foi estabelecido qual é o melhor método.Um trabalho pioneiro nesse sentido foi feito por Edwin Hubble (1934, Astrophysical Journal, 79, 8), que fez um extenso estudo da distribuição de galáxias no espaço e encontrou um número maior de galáxias nas regiões próximas aos pólos galácticos, e um número cada vez menor à medida que se aproximava do plano da Via Láctea, onde ele estimou um enfraquecimento da luz em 0.25 mag (no sistema fotográfico). Hubble encontrou que seus dados ajustavam bem uma lei de

O tipo de análise feita por Hubble foi repetido e confirmado por vários outros autores. Charles Donald Shane e Carl Alvar Wirtanen (1910-1990) (1967, Publications of the Lick Observatory, 22, 1) aplicaram a lei de cosecante a contagens de galáxias, mas encontraram um valor para o coeficiente de absorção de 0.5, o dobro do valor obtido por Hubble; Erik Holmberg [1975, Galaxies and the Universe. Edited by Allan Sandage (1926-2010), Mary Sandage, and Jerome Kristian. University of Chicago Press (Stars and Stellar Systems. Volume 9), Chicago, IL USA., p.123] aplicou a mesma lei às magnitudes superficiais de galáxias Sa-Sb-Sc, encontrando um coeficiente de absorção de 0.26, quase o mesmo valor de Hubble; Allan Sandage (1973, Astrophysical Journal, 183, 711) adotou um modelo um tanto hipotético em que a extinção segue uma lei de cosecante para valores de

No modelo proposto por Gerard Henri de Vaucouleurs (1918-1995), Antoinette de Vaucouleurs (1921-1987) e Harold G. Corwin no [1976, Second Reference Catalogue (RC2)], baseado num trabalho anterior de de Vaucouleurs e G. M. Malik (1969, Monthly Notices of the Royal Astronomical Society, 142, 387) em que eles reanalisaram os dados de Hubble, a extinção em magnitudes na banda B tem a forma:

ou

onde

Esse modelo adotado no RC2 não admite o conceito de janelas polares, mas também não dá nenhuma demonstração de que a lei cosec b se aplica para altas latitudes. No entanto, em um estudo feito por Gerard de Vaucouleurs e Ron Buta (1983, Astronomical Journal, 88, 939), usando cinco diferentes indicadores do avermelhamento, eles concluiram que de fato existe poeira mesmo nos pólos, além de confirmar o valor médio de 0.2 para o coeficiente de extinção.

Outro traçador da extinção Galáctica é a distribuição de hidrogênio neutro, que foi usado em combinação com contagens de galáxias no método de Dave Burstein e Carl Heiles (1978, Astrophysical Journal, 225, 40, 1982, Astronomical Journal, 87, 1165) o qual foi adotado no "Surface Photometry Catalogue of the ESO - Uppsala Galaxies" (Andris Lauberts e Edwuin A. Valentijn, 1989, daqui em diante SPC). Esses autores concluíram que nem contagens de galáxias nem distribuição de hidrogênio podem, sozinhos, predizer o avermelhamento, primeiro porque os dados têm espalhamento muito grande para que a variação de contagens de galáxias com cosec b seja significativa; segundo porque a razão gás-poeira não é constante. Porém, através da relação entre esses dois indicadores, pode-se derivar a razão variável gás-poeira e daí determinar o avermelhamento. Eles encontraram duas expressões adequadas para descrever o avermelhamento:

ou

Na primeira expressão, R é uma correção para a razão gás-poeira, e contém a dependência com cosec b, a qual Dave Burstein e Carl Heiles acreditam ser um problema devido a efeitos seletivos nos dados usados por Carl Heiles (1976, Astrophysical Journal, 204, 379) para derivar R; NH é a densidade de coluna do hidrogênio neutro e Ngal é o número de galáxias. As duas expressões são igualmente corretas para

Os dados de Ngal usados por Dave Burstein e Carl Heiles se baseiam nos números dados por Charles Donald Shane e Carl Alvar Wirtanen (1910-1990) (1967, Publications of the Lick Observatory, 22, 1) que não contém objetos com declinação < -23o. Portanto para objetos de declinação mais ao sul que isso, eles aplicam a equação

que pode conter grandes erros na predição de E(B-V) devido à variação na razão gás-poeira.

Douglas P. Finkbeiner, David J. Schlegel e Marc Davis, no artigo A limit on galactic extinction not correlated with far IR emission, publicado em 1998 no Lecture Notes in Physics, Volume 506, 1616, reprocessaram os mapas IRAS - Infra Red Astronomical Satellite e DIRBE - Diffuse Infrared Background Experiment (DIRBE) no Cosmic Background Explorer (COBE) Satellite, de 100 µm, usando as medidas de HI como ponto zero, para produzir um mapa da extinção Galática.

Douglas Marshall, Annie C. Robin e Céline Reylé, no artigo de 2008, The Use of Near Infrared Extinction to Constrain the Dusty Spiral Structure of the Milky Way publicado no Bulletin of the American Astronomical Society, Vol. 40, p.213, usam as observações estelares do 2MASS - The Two Micron All Sky Survey para determinar um modelo tridimensional de extinção na Via Láctea.

E os grandes catálogos 2dF - Two Degree Field Quasar Survey, no hemisfério sul, e SDSS - Sloan Digital Sky Survey, no hemisfério norte, permitiram uma mapeamento de galáxias muito superior aos usados nas determinações anteriores.

Extinção Interna

Sistemas estelares externos, assim como a Galáxia, são constituídos de estrelas misturadas com gás e poeira. A poeira produz efeitos de extinção que se tornam importantes principalmente em galáxias orientadas de perfil em relação à linha de visada, pois a poeira tende a se concentrar no plano do disco. Portanto a extinção interna é uma função da inclinação i da galáxia.De acordo com Jean Heidmann, Nicole Heidmann & Gerard de Vaucouleurs (1972, Memoires of the Royal Astronomical Society, 75, 85), a absorção interna em B, é dada por:

A inclinação está fortemente relacionada com a variável log R25, que é o logaritmo decimal da razão entre os diâmetros maior e menor na isofota de brilho superficial

onde

Correção pelo "Redshift"

O redshift desloca todo o espectro da galáxia, modificando os fluxos que passam pelas bandas espectrais dos filtros. O efeito do redshift nas magnitudes, denominado correção-K, é a diferenç a de magnitude entre uma distribuição espectral de energia afetada pelo redshift e a não afetada. De acordo com o RC2, depois de William D. Pence (1976, Astrophysical Journal, 203, 39), a correção K é diretamente proporcional à velocidade radialonde k'B(T) depende do tipo morfológico, c é a velocidade da luz, e z é o parâmetro de redshift. A correção no índice de cor B-V é similar, variando o coeficiente K'B-V. Os coeficientes K'B e K'B-V são listados abaixo.

Correção por Efeito do Seeing

A distribuição de luz observada em uma imagem astronômica,onde

Uma vez determinada a PSF, existem duas maneiras básicas de extrair a distribuição verdadeira a partir de observações contaminadas por seeing. Uma delas é supor um modelo para o objeto observado, convoluir esse modelo com o seeing, e então ajustar o modelo convoluído às observações. Esse método tem a desvantagem de que os núcleos das galáxias, que são as regiões mais afetadas pelo seeing, não seguem uma lei de distribuição de brilho padrão, de forma que fica difícil decidir que modelo ajustar. A outra maneira é aplicar algum método de de-convolução diretamente sobre as observações.

Vários métodos de de-convolução têm sido propostos por diferentes autores (Ronald N. Bracewell 1955, Journal of the Optical Society of America, 45, 873; Tod R. Lauer 1985, Astrophysical Journal, 292, 104; Orazio Bendinelli, Gianluigi Parmeggiani & Franco Zavatti, 1986, Astrophysical Journal, 308, 611), mas o que tem provado ser o mais eficiente é o desenvolvido por Leon B. Lucy (1974, Astronomical Journal, 79, 745), que foi implementado como uma sub-rotina especialmente desenvolvida para fotometria de galáxias no Observatório Astronômico de Pádua, na Itália, por Massimo Capaccioli. O método numérico de Lucy permite encontrar uma função F(x) que esteja relacionada a uma função observável f(x') pela integral

onde P(x',x) é uma distribuição de probabilidades que pode ser identificada com a PSF no caso em que f(x') é a distribuição de brilho observada e F(x) é a distribuição de brilho verdadeira que se quer determinar. Lucy segue uma técnica iterativa para estimar F(x): a partir de uma P(x',x) conhecida, ele sugere como primeira aproximação para F(x) a própria f(x') para estimar a probabilidade inversa Q(x,x') = F(x)P(x',x)/f(x'), e calcula a segunda aproximação para F(x) pela integral

O processo continua até que algum critério de convergência seja atingido. O maior problema do algoritmo é a falta de um critério objetivo de convergência. Lucy dá um limite de 5 a 10 iterações, mas nos testes feitos para restaurar as imagens do Hubble Space Telescope, usando este mesmo método, a convergência ocorreu após 20 iterações (P. Hertz e M. L. Cobb 1991, The First Year of HST Observations. Proceedings of a workshop held at the Space Telescope Science Institute, Baltimore, Maryland, May 14-16, 1991. Editors, A.L. Kinney, J.C. Blades; Publisher, Space Telescope Science Institute, Baltimore, MD), e Massimo Capaccioli (1988, Boletin Academia Nacional Ciencias de Cordoba, Argentina, Tomo 58, p. 317) cita outros casos em que a convergência ocorre somente após 15 ou 20 iterações.

Spline é uma função polinomial suave (com derivada nas bordas igual a zero, isto é, com curvatura zero) e somente definida por intervalos; elimina a oscilação nas bordas presente quando se usa polinomios de alto grau, efeito descoberto pelo matemático alemão Carl David Tolmé Runge (1856-1927), e similar ao fenômeno de Gibbs [Josiah Willard Gibbs (1839-1903)] que são as oscilações nas transformadas de Fourier causadas por descontinuidades.

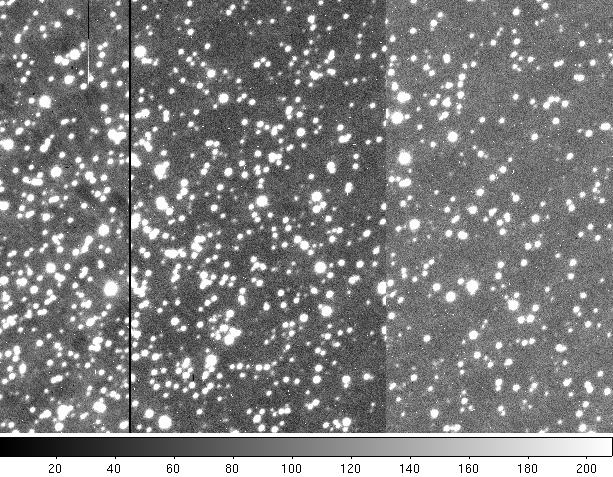

Fotometria de um aglomerado

Espectroscopia

Mais detalhes sobre observações (em inglês)

Mais detalhes sobre CCDs (em inglês)

Modificada em 26 mar 2013

Sem comentários:

Enviar um comentário